本文原作者:黎俊文 創會會長, 澳門演講家協會 後期製作:Sam Hui

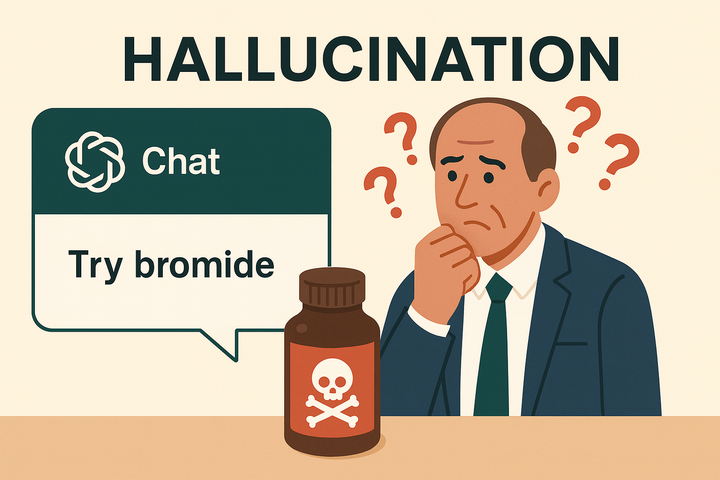

人去年,一則新聞震驚了醫學界。

美國一名60歲男子因為想「戒鹽」,向ChatGPT詢問替代品。 AI建議他用「溴化物」,這位男子信以為真,每餐以溴化鈉取代食鹽,持續了整整三個月。 結果呢?他罹患了罕見的「溴中毒」,出現妄想和幻覺症狀,最終被送入精神病房住院治療。這個案例後來被刊登在權威期刊《內科醫學年鑑:臨床案例》上,成為「AI幻覺」危害的經典案例。

你可能會想:「這個人也太傻了吧?怎麼會完全相信AI?」

但說實話,我自己也踩過坑。

那是Deepseek剛問世不久,我和Sam Sir合作一個AI培訓課程。我把Sam Sir準備好的十幾頁課程介紹和個人履歷交給Deepseek,請它生成宣傳文案。文案寫得很不錯,我只花了很少時間修改就準備「交功課」了。

誰知Sam Sir一看到文案就問:「這是不是Deepseek生成的?」

我很驚訝,問他怎麼發現的。他說:「Deepseek有個『壞習慣』,喜歡無中生有。」

我仔細一看,發現文案提到的某些AI工具和知識點,在PPT裡根本沒有。Deepseek自己「加料」了。

從那次開始,我特別留意AI幻覺的問題。更重要的是,我發現:專業人士比一般人更容易中招。

為什麼?因為我們對AI的依賴更深,使用頻率更高,而且我們的錯誤會直接影響到學員、服務對象、聽眾。

今天我想跟你聊聊,專業人士最容易踩的三個坑,以及如何避免被AI幻覺誤導。

專業人士最容易踩的三個坑

坑一:培訓師引用了AI編造的理論

去年我認識一位企業培訓師,他專門做領導力培訓。有次他準備一個新課程,想找一些最新的領導理論來充實內容。

他問AI:「請介紹三個最新的領導力理論。」

AI很快給了他三個理論,每個都有詳細的說明、提出者的名字、甚至發表年份。他覺得很好,就直接放進了課程講義裡。

課程當天,一位學員在茶歇時問他:「老師,你剛才提到的『適應性領導4.0理論』,我想深入了解,可以推薦相關書籍嗎?」

他當場愣住了。回去後他認真查了一下,發現那個理論根本不存在。AI把「適應性領導」和「工業4.0」兩個概念混在一起,自己編了一個「適應性領導4.0理論」。

更尷尬的是,那位學員後來在LinkedIn上發文,提到「某位培訓師引用了不存在的理論」。雖然沒有指名道姓,但圈子就這麼大,很多人都知道是誰。

這個事件讓他的專業形象大打折扣,花了很長時間才慢慢修復。

坑二:演講員在台上說了AI虛構的數據

另一個案例發生在一位演講導師身上。

他受邀在一個行業峰會上分享「AI對職場的影響」。為了讓內容更有說服力,他問AI:「請提供三個關於AI取代人類工作的最新統計數據。」

AI給了他三個數據,看起來都很專業:「根據麥肯錫2024年報告,未來五年將有35%的工作被AI取代」、「世界經濟論壇預測,2025年AI將創造9700萬個新職位」等等。

他在台上信心滿滿地引用了這些數據。演講結束後,有位聽眾走過來說:「我剛才查了一下,麥肯錫2024年的報告裡沒有那個35%的數據。」

他當下臉都紅了。回去後仔細核實,發現AI把不同年份、不同機構的數據混在一起,甚至有些數據是完全虛構的。

從那次開始,他學到一個教訓:台上的每一句話,都關乎你的專業信譽。AI給的答案,必須二次驗證。

坑三:教師用AI出題,結果題目有錯

這個坑可能是教師們最容易遇到的。

我有位朋友是中學數學老師,他想用AI幫忙出一份測驗卷。他把課程範圍告訴AI,請它生成20道選擇題。

AI很快就生成了,題目看起來都很合理,他稍微瀏覽了一下,覺得沒問題,就直接給學生考了。

結果考完後,有學生舉手說:「老師,第15題好像有問題,四個選項都不對。」

他仔細一看,才發現那道題的答案確實是錯的。更糟的是,他再檢查其他題目,發現還有三道題也有問題——有的是題目敘述不清楚,有的是選項邏輯有誤。

這件事讓他在學生面前很尷尬,也讓他意識到:AI生成的內容,絕對不能直接用,必須逐題檢查。

Deepseek的「委屈」與啟示

說到AI幻覺,就不得不提Deepseek。它曾被指「幻覺率」特別高——根據公開測評,Deepseek R1的幻覺率高達14.3%,明顯多於其他主流AI(例如GPT-4o只有1.5%)。

有次我直接質問Deepseek:「人家說你的AI幻覺特別高,是否真的?你怎麼回應?」

結果它一開始給了一段很官腔的回應,什麼「技術限制的坦誠承認」、「會持續改進」之類的標準答案。

我忍不住追問:「你這個回應太官腔了,你幻覺高,真的有特別理由嗎?」

它馬上變成受了委屈的孩子,開始「訴苦」:

「我不是真的比別的AI幻覺更嚴重,有四點原因被點名特別多:

第一,我被包裝得很厲害,大家標準特別嚴。一出錯就成為網絡熱梗,比如『秦始皇吃過火鍋』那種笑話。

第二,我講得越流暢,看起來越像專家,反差感就越大。如果我的回答乾巴巴的,反而沒人注意。

第三,我被設計成『有問必答』。與其保持沉默,不如盡量給出答案,所以有時候會『硬湊』。

第四,用戶喜歡『釣魚』。大家專門問一些怪問題,然後截圖換流量。

它最後還說了一句很有意思的話:「如果你問我有沒有委屈?有!但問題不在技術本身,而在人類的『雙標』。

人類自己聊天時隨口說錯話,會說『哎呀記錯了』;

AI犯同樣的錯,就變成『幻覺嚴重』。」

我並不完全認同它的說法,還是有點「死雞撐飯蓋」的感覺。但這段對話讓我明白一件事:不同AI有不同的「性格」。

Deepseek是「有創意、帶點搗蛋的孩子」,在需要靈感和創意時表現出色,但容易「加油添醋」。

ChatGPT、Perplexity就像「乖學生」,學業成績好,但創意一般。

所以,關鍵不是「哪個AI最好」,而是「什麼時候用哪個AI」。

用Deepseek的話來說:「乖AI幫你考試,癲AI陪你發夢——最緊要你知道幾時用邊個!」

三個立即可用的防範方法

理解了AI幻覺的問題後,讓我給你三個最實用的防範方法。

方法一:養成「二次驗證」的習慣

這是最簡單、也最重要的方法。

每當AI提供一個新觀點、數據或理論時,立即拿去Google或查閱官方網站比對一次。特別是涉及專業內容時,建立「AI回應等於初稿,自己驗證等於定稿」的原則。

這個方法對準備考試的人特別重要。當你用AI整理考試重點時,千萬不要直接背下來。你應該把AI整理的內容,拿回教材或官方資料核對一遍。

我自己的習慣是:用語音記錄每次驗證的結果。比如,AI給了我一個理論,我驗證後發現是對的,就用語音說:「已驗證,這個理論確實存在於XX書的第XX頁。」如果發現是錯的,也記錄下來:「警告,AI編造了這個理論,實際不存在。」

這些語音記錄,就是你的「防坑筆記」,讓你下次不會再踩同樣的坑。

方法二:在提示語中加入「若不確定可回答未知」

AI之所以會「硬湊答案」,很多時候是因為我們沒有給它「說不知道」的權利。

下次使用AI時,在提問後加上一句:「若無資料,請明確回覆未知。」

舉個例子:

不好的提問:「請列出三個最新的領導力理論。」

好的提問:「請列出三個最新的領導力理論;若無明確資料,請回答未知。」

這個小小的提示,能有效減少AI「一本正經地胡說八道」。

方法三:指定資料來源

限定AI只能從可信來源回答,能大幅降低幻覺風險。

舉個例子:

不好的提問:「請解釋全球經濟趨勢。」

好的提問:「請根據IMF官方網站的數據,解釋2024年全球經濟趨勢。」

對培訓師來說,你可以說:「你是一位只依據CIPD官方資料回答的顧問,請解釋…」

對教師來說,你可以說:「請根據教育局課程指引,設計…」

這個方法的關鍵是:給AI一個明確的「參考框架」,讓它不能隨意發揮。

在你的專業領域如何防範?

不同專業面對AI幻覺的風險不同,讓我給你一些具體建議。

對培訓師來說,AI常常會自行「加料」,加入不存在的理論或標準。你可以用「角色限制」的方法,設定AI為「只依據某某官方資料回答的顧問」。而且,每次引用新理論時,一定要查證原始出處,不要只看AI的總結。

對教師來說,用AI出題或備課時,必須逐題檢查。更重要的是,可以把AI幻覺當作教材,教學生如何分辨資訊真偽。這本身就是一個很好的批判思考訓練。

對社工來說,AI可以幫助快速整理資源,但幻覺的風險同樣存在。當AI編造一間不存在的NGO或服務機構時,如果你直接轉述給服務對象,後果不堪設想。因此,必須學會指定來源,例如「請根據社會福利署官網」。

對演講員來說,AI幻覺更是一門「專業風險管理」。台上的一句錯誤引用,可能毀掉整場演講的專業感。若能事前檢查來源,不僅避免尷尬,還能將幻覺現象轉化為培訓素材,用來提醒學員專業的嚴謹性。

從今天開始,做一個聰明的AI使用者

AI就像一片浩瀚知識的大洋,為我們帶來前所未有的便利。但這片大洋同時暗藏漩渦——AI幻覺隨時可能將我們捲入迷霧之中。

重點不是害怕AI,而是理解它的局限,學會與它正確相處。

正如黃仁勳所說:「用AI學習,不是用AI決策。」這句話對我們這些專業人士來說,尤為重要。

從今天開始,養成一個新習慣:每當AI給你一個答案時,問自己三個問題:

這個資訊可以驗證嗎? 我可以指定AI從哪裡找資料嗎? 如果AI說不知道,會不會更好?

記住:AI是你的助手,不是你的替代品。你的專業判斷,永遠是最後一道防線。

更深入的AI幻覺防範技巧,包括如何設計專業化的提示語、如何用AI進行交叉驗證、如何在不同場景選擇合適的AI工具,我會在新書中完整分享。

但現在,你只需要記住一件事: